- Introdução à CLI do Gemini

A Interface de Linha de Comando (CLI) do Gemini representa uma ferramenta inovadora, de código aberto, desenvolvida pelo Google, que integra o poder dos modelos de inteligência artificial (IA) Gemini diretamente no ambiente de terminal de um desenvolvedor. Concebida como um agente de IA baseado em terminal, a CLI do Gemini atua como um assistente versátil, capaz de executar uma vasta gama de tarefas, desde a escrita e depuração de código até a geração de conteúdo e o gerenciamento de tarefas.

O Google posiciona a CLI do Gemini não apenas como mais uma ferramenta, mas como uma “atualização fundamental para a experiência da linha de comando”. Essa perspectiva decorre do reconhecimento de que o terminal é um ambiente central, quase um “lar”, para muitos desenvolvedores. A intenção é incorporar a assistência de IA de forma fluida nesse ambiente familiar, visando um aumento significativo da produtividade. A decisão de tornar a ferramenta de código aberto e acessível gratuitamente para a maioria dos usuários representa uma abordagem estratégica do Google. Ao reduzir as barreiras de entrada, a empresa busca incentivar a adoção em larga escala e o engajamento da comunidade. Essa estratégia pode, por sua vez, impulsionar o consumo futuro de serviços de nuvem ou o uso de modelos de IA, diferenciando-se de modelos mais fechados ou exclusivamente pagos e indicando uma visão de longo prazo para a predominância do ecossistema.

- Conceitos e Funcionalidades Essenciais

2.1 CLI do Gemini (Definição Geral)

A CLI do Gemini é um agente de IA de código aberto que oferece acesso direto aos modelos Gemini do Google a partir do terminal. Sua arquitetura é construída sobre um ciclo de “raciocinar e agir” (ReAct), o que a capacita a planejar, executar e iterar em tarefas complexas, distinguindo-a de ferramentas de preenchimento automático mais simples. Essa capacidade de planejar e executar ações em várias etapas no ambiente do desenvolvedor, em vez de apenas fornecer sugestões de código, marca uma evolução significativa. Isso posiciona a CLI do Gemini como um verdadeiro “agente” ou “co-piloto” de IA, capaz de lidar com fluxos de trabalho complexos de ponta a ponta e potencialmente reduzir a carga cognitiva dos desenvolvedores.

A ferramenta se destaca em tarefas de codificação, como correção de bugs, criação de novas funcionalidades e aprimoramento da cobertura de testes. No entanto, sua utilidade se estende muito além da codificação, funcionando como uma ferramenta local versátil para geração de conteúdo, resolução de problemas e pesquisa aprofundada. Ela pode ler, modificar e gerar código em arquivos locais usando instruções em linguagem natural, e também executar comandos no sistema do usuário. No cerne de suas operações, a CLI do Gemini se conecta ao modelo de linguagem grande (LLM) Gemini 2.5 Pro do Google, que é o modelo de IA mais avançado da empresa para tarefas de raciocínio e codificação, caracterizado por uma vasta janela de contexto de 1 milhão de tokens.

2.2 CLI do Google Gemini

Lançada pelo Google em meados de 2025, a CLI do Google Gemini foi desenvolvida para trazer o poder dos modelos de IA Gemini diretamente para os terminais dos desenvolvedores. Sua integração profunda com o ecossistema Google é evidente, incluindo potenciais conexões com serviços como Google Search, YouTube e Drive. Essa integração aproveita a vasta base de usuários e a infraestrutura de serviços existentes do Google para impulsionar a adoção.

O acesso à CLI do Gemini é facilitado pelo login com uma conta pessoal do Google, que concede acesso ao Gemini 2.5 Pro com um nível gratuito generoso, permitindo até 60 solicitações por minuto e 1.000 por dia. Para usuários com necessidades de limites mais altos ou modelos específicos, é possível utilizar chaves de API. A oferta de um nível gratuito substancial, uma estratégia comum do Google, visa capturar uma fatia de mercado e coletar dados de uso, embora as APIs com faturamento ativado ofereçam garantias de privacidade. Essa abordagem cria um poderoso efeito de rede, facilitando a coleta de feedback e o aprimoramento do modelo, enquanto potencialmente direciona os usuários para as ofertas mais amplas de nuvem do Google.

2.3 Interface de Usuário (UI) da CLI do Gemini

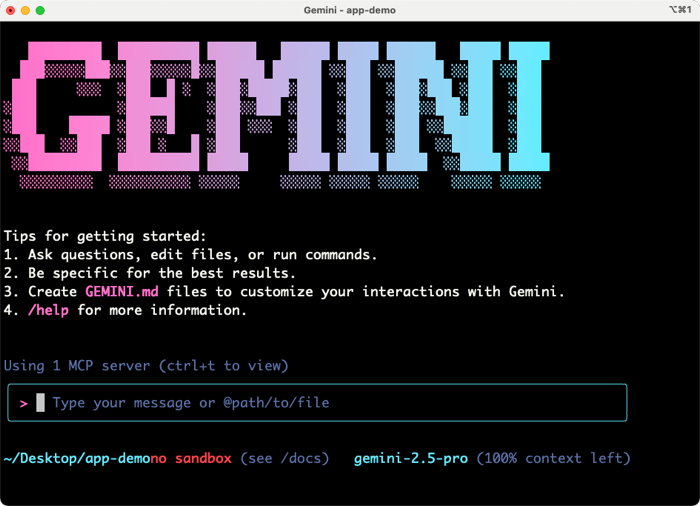

A CLI do Gemini opera como uma interface baseada em terminal, exigindo familiaridade com comandos de linha de comando. Ela oferece uma experiência interativa, semelhante a um shell, com uma caixa de texto para entrada do usuário. Embora seja predominantemente baseada em texto, a ferramenta inclui elementos visuais como um banner ASCII no lançamento e a opção de escolher um tema de cor (claro ou escuro) na primeira execução. Alguns usuários observam a ausência de elementos visuais mais ricos em comparação com ferramentas baseadas em interface gráfica de usuário (GUI) e expressam o desejo por uma UI mais completa.

Apesar de sua natureza baseada em terminal, a CLI do Gemini oferece uma integração profunda com Ambientes de Desenvolvimento Integrados (IDEs), como o VS Code. Nesses ambientes, ela é executada dentro do terminal integrado e pode se tornar “ciente dos arquivos abertos e acessar o texto selecionado”. Isso permite a visualização de diferenças (diffing) nativa no editor para as alterações sugeridas. A coexistência de uma interface baseada em terminal com uma integração profunda em IDEs demonstra uma escolha de design estratégica. O Google reconhece que, embora o terminal seja um ambiente central, grande parte do trabalho detalhado de codificação ocorre dentro das IDEs. Ao fornecer uma “extensão complementar” que permite a consciência do contexto (arquivos abertos, texto selecionado) e a visualização de diferenças nativa

dentro da IDE, a CLI do Gemini busca oferecer o melhor dos dois mundos: o poder e a direcionalidade de um agente CLI combinados com os benefícios visuais e interativos de uma IDE. Isso sugere um futuro onde os agentes de IA se integram perfeitamente em ambos os ambientes, adaptando-se à preferência do desenvolvedor em vez de forçar uma única interface. A visualização de diferenças nativa é uma melhoria crucial na experiência do usuário, abordando uma queixa comum sobre a legibilidade das propostas de mudança baseadas em CLI.

2.4 Gemini CLI 2.0 / Novas Atualizações da CLI do Gemini

Embora o termo “Gemini CLI 2.0” seja uma consulta, as informações disponíveis referem-se a atualizações gerais da ferramenta. Uma atualização notável introduziu um “Modo Gratuito” (-f, –free), que permite o uso sem a necessidade de uma chave de API e automaticamente recorre a esse modo caso nenhuma chave seja fornecida. Essa atualização também focou em “Scripting e Automação Sérios”, com recursos como Modo Silencioso (

-q), Modo de Execução (-e) e salvamento de sessão (–save-session) para execuções não interativas.

A ferramenta tem recebido melhorias contínuas em confiabilidade e conectividade, incluindo tentativas automáticas para chamadas de API em caso de erros 503 e suporte a proxy. O sistema de anexos de arquivos e fluxos foi reescrito para maior robustez. A CLI do Gemini está em constante desenvolvimento, com atualizações frequentes que visam atender ao feedback dos usuários e aprimorar suas capacidades. Exemplos incluem a detecção aprimorada de código com a biblioteca

marked, uma função findProjectRoot otimizada para desempenho e novas flags –import-format (árvore/plano) para o contexto da memória. Há também suporte para carregamento seguro de arquivos e comentários de fallback para importações inválidas. Os usuários são aconselhados a atualizar a aplicação regularmente. A descrição detalhada dessas atualizações indica que o produto está passando por uma rápida iteração. A introdução do “Modo Gratuito” aborda diretamente uma barreira primária de entrada (configuração de chave de API), demonstrando atenção à experiência do usuário. Da mesma forma, recursos como o “Modo Silencioso” e o “Modo de Execução” para scripting mostram um foco em usuários avançados e automação, indicando o amadurecimento da ferramenta. As melhorias contínuas em confiabilidade (tentativas, suporte a proxy, manipulação de anexos) e gerenciamento de contexto (biblioteca

marked, formatos de importação) sugerem que o Google está trabalhando ativamente para resolver as “preocupações com maturidade e estabilidade” relatadas pelos primeiros usuários. Esse ciclo de desenvolvimento rápido é crucial para que uma ferramenta de IA em estágio inicial ganhe confiança e compita eficazmente.

2.5 CLI do Gemini e MCP

A CLI do Gemini oferece suporte a servidores do Protocolo de Contexto do Modelo (MCP). O MCP é um padrão que permite à CLI conectar-se a bancos de dados, APIs e documentação, ampliando sua utilidade ao buscar informações externas e enriquecer as respostas. O suporte ao MCP é um elemento chave do modelo de extensibilidade da CLI do Gemini, permitindo que os desenvolvedores conectem serviços externos e adicionem novas capacidades. Isso posiciona a ferramenta como uma plataforma, não apenas uma aplicação de propósito único. Por exemplo, pode ser usado para aprimorar fluxos de trabalho, buscando documentação em tempo real ou integrando-se com servidores MCP do GitHub.

A menção explícita do “Protocolo de Contexto do Modelo (MCP)” é um detalhe técnico crucial. Ao adotar ou promover um padrão como o MCP, o Google não está apenas construindo uma ferramenta autônoma, mas visando um ecossistema. Isso permite uma “assistência de IA altamente personalizada” e posiciona a CLI do Gemini como uma “plataforma”. A implicação é que os desenvolvedores não estão limitados às ferramentas integradas do Google; eles podem integrar seus próprios sistemas proprietários, bancos de dados e APIs. Isso amplia significativamente a aplicabilidade da CLI do Gemini, tornando-a mais atraente para casos de uso empresariais onde integrações personalizadas são primordiais, e potencialmente fomentando uma comunidade mais ampla de desenvolvedores de ferramentas em torno do padrão MCP.

2.6 Configuração e Instalação da CLI do Gemini

A instalação da CLI do Gemini requer um ambiente de linha de comando (Terminal no macOS/Linux, PowerShell no Windows) e Node.js (versão 20 ou superior, embora algumas fontes mencionem v18 ou v22) e npm. Recomenda-se o uso do NVM (Node Version Manager) para gerenciar as versões do Node.js.

Existem vários métodos de instalação:

Homebrew (macOS): brew install gemini-cli.

npm (qualquer SO): npm install -g @google/gemini-cli.

npx (qualquer SO): npx https://github.com/google-gemini/gemini-cli.

Após a instalação, a execução de gemini iniciará a CLI. Na primeira execução, o usuário é solicitado a escolher um tema de cor e, em seguida, a autenticar-se. É possível fazer login com uma conta pessoal do Google para acessar o nível gratuito ou definir uma chave de API como variável de ambiente (GEMINI_API_KEY=”SUA_CHAVE”). O comando

/auth permite alternar os métodos de autenticação. A CLI do Gemini é compatível nativamente com Windows, sem a necessidade do Subsistema Windows para Linux (WSL), o que resulta em inicialização mais rápida e melhor integração.

Os múltiplos e relativamente simples métodos de instalação (Homebrew, npm, npx) e o “modo gratuito” que não exige chave de API demonstram um forte foco na acessibilidade do desenvolvedor e na facilidade de adoção para indivíduos. No entanto, a opção de usar chaves de API e a menção de variáveis de ambiente (

GEMINI_API_KEY) também apontam para a prontidão empresarial, onde o gerenciamento de chaves de API e a integração em pipelines de CI/CD são comuns. O suporte nativo ao Windows amplia ainda mais seu apelo, já que muitos ambientes corporativos são baseados em Windows. Essa abordagem dupla visa atrair tanto desenvolvedores individuais quanto grandes organizações, mas o “modo gratuito” pode criar uma percepção de uma ferramenta menos “pronta para produção” para alguns usuários corporativos, apesar da opção de chave de API.

2.7 Tutorial e Uso da CLI do Gemini

Uma vez autenticado, o usuário interage com a CLI por meio de uma caixa de texto no terminal. Comandos básicos como

/help exibem os comandos e atalhos disponíveis, incluindo como usar @ para especificar arquivos/pastas para contexto. A CLI do Gemini pode ser utilizada para iniciar novos projetos (por exemplo,

cd new-project/, seguido de gemini e um prompt para código) ou trabalhar com bases de código existentes (clonando um repositório Git, navegando até ele e executando gemini). O comando /path permite carregar projetos locais manualmente.

A ferramenta inclui “ferramentas” integradas, como grep, terminal, leitura de arquivo, escrita de arquivo, echo, pesquisa web e busca web. Essas ferramentas permitem que ela execute tarefas como procurar documentação, solucionar erros online ou buscar exemplos. Ela pode executar comandos e reagir à sua saída. A CLI do Gemini é capaz de explorar e compreender bases de código, detectar bugs, refatorar código, gerar testes unitários, criar relatórios em Markdown e visualizar o código. Ela propõe alterações que os usuários podem revisar e aplicar. Também suporta o “modo shell” (

!) para interagir diretamente com o shell do sistema.

A capacidade de “ler, escrever e executar comandos de shell” , realizar “automação de tarefas de ponta a ponta” e “fazer alterações em cada arquivo afetado” , combinada com a “interface gráfica de usuário (GUI) com intervenção humana para aprovar cada alteração de arquivo e comando de terminal” , revela um design de agente sofisticado. Não se trata apenas de responder a perguntas; a IA está ativamente

executando o trabalho no ambiente do desenvolvedor. O aspecto de “intervenção humana” é crucial para a segurança e o controle, mitigando os riscos associados a agentes totalmente autônomos. Isso significa uma mudança para a IA não apenas aconselhando, mas participando diretamente e automatizando fluxos de trabalho de desenvolvimento complexos, com o desenvolvedor mantendo a supervisão e a aprovação final.

- Desempenho, Avaliações e Comparações

3.1 Avaliação da CLI do Gemini / Avaliação da CLI do Gemini 2025

As avaliações sugerem que a CLI do Gemini é uma ferramenta promissora, especialmente devido à sua natureza de código aberto e nível gratuito. É vista como uma “atualização fundamental” para a linha de comando. Os usuários valorizam sua capacidade de trazer IA poderosa diretamente para o terminal, sua natureza de código aberto e seus generosos limites de uso gratuito. Ela é capaz de lidar com tarefas complexas e gerar um código inicial decente.

No entanto, existem preocupações e pontos fracos:

Maturidade e Estabilidade: Muitos usuários a descrevem como “em estágio inicial de desenvolvimento”, “instável”, “propensa a entrar em um ciclo vicioso” e com “arestas” ou “bugs”. Pode exigir “supervisão constante”.

Consistência do Modelo (Nível Gratuito): Uma frustração significativa é que o nível gratuito frequentemente “reverte do poderoso Gemini 2.5 Pro para o menos capaz modelo Gemini Flash” após algumas interações, degradando a qualidade das respostas. Isso afeta sua imagem de “barato”.

Desempenho de Codificação: Embora capaz, alguns desenvolvedores consideram que para tarefas de codificação complexas, concorrentes como o Claude Code são “significativamente melhores”. Usuários relatam que a ferramenta tem dificuldades com tarefas além da codificação básica, às vezes fazendo alterações no ambiente que quebram projetos, revertendo para contextos antigos ou “desistindo” de bugs complexos. Um usuário relatou que a ferramenta consumiu 7 milhões de tokens e 20-25 minutos sem conseguir concluir uma tarefa não trivial.

Experiência do Usuário (UX/UI) no Terminal: A experiência baseada apenas em texto no terminal pode ser menos intuitiva para aqueles acostumados a interfaces gráficas ricas. Seu formato para propor mudanças no terminal pode ser difícil de ler.

Problemas de Gerenciamento de Contexto: Às vezes, a ferramenta usa versões antigas de arquivos, apesar das atualizações, ou propõe alterações vazias, exigindo reinícios de sessão.

Sistema de Permissões: Seu sistema de permissões é considerado vago em comparação com os concorrentes.

As avaliações pintam um quadro claro de uma ferramenta em desenvolvimento ativo. O “nível gratuito generoso” e a natureza de “código aberto” são grandes atrativos, promovendo a adoção rápida e a experimentação. No entanto, o feedback consistente sobre “preocupações com maturidade e estabilidade” , a “degradação do modelo no nível gratuito” e as “dificuldades com tarefas complexas” indicam que, embora seja inovadora e acessível, a ferramenta pode ainda não ser robusta o suficiente para fluxos de trabalho de produção críticos para todos os usuários. Isso cria um dilema para potenciais adotantes: abraçar a ferramenta de ponta, econômica e em rápida evolução, ou optar por alternativas mais maduras, potencialmente mais caras, mas mais confiáveis. A menção de “avaliação 2025” sugere um estado futuro em que esses problemas podem ser resolvidos, mas o feedback atual aponta para desafios de crescimento contínuos.

3.2 Prós e Contras da CLI do Gemini

Prós:

Custo-Benefício e Acessibilidade: Totalmente gratuita com uma conta pessoal do Google, oferecendo limites generosos de solicitações diárias e por minuto.

Código Aberto: Completamente de código aberto, permitindo transparência, contribuições da comunidade e personalização.

Ampla Janela de Contexto: 1 milhão de tokens (em breve 2 milhões), ideal para compreender grandes bases de código e manter a coerência da conversa.

Acesso Direto ao Sistema de Arquivos e Automação: Pode ler, escrever e executar comandos de shell, permitindo automação de tarefas de ponta a ponta e refatoração complexa.

Versatilidade: Além da codificação, lida com geração de conteúdo, resolução de problemas, pesquisa aprofundada e gerenciamento de tarefas.

Suporte Nativo ao Windows: Funciona nativamente no Windows sem WSL.

Extensibilidade: Suporta servidores MCP para conexão com APIs externas, bancos de dados e fluxos de trabalho personalizados.

Recursos de Segurança: Inclui sistema de checkpointing (/restore) e protocolos de confirmação do usuário para alterações destrutivas.

Contras:

Maturidade/Estabilidade: Descrita como “versão alfa inicial”, “instável”, propensa a “ciclos viciosos” e com “arestas”.

Degradação do Modelo (Nível Gratuito): Frequente reversão do Gemini 2.5 Pro para o menos capaz Gemini Flash, degradando a qualidade.

Desempenho/Confiabilidade de Codificação: Pode ter dificuldades com tarefas complexas, quebrar projetos ou “desistir” de bugs. Pode ser lento.

Experiência do Usuário (UX/UI) no Terminal: Menos visual e interativa que ferramentas GUI; a experiência apenas em texto pode ser menos intuitiva para alguns. A visualização de diferenças (diffing) pode ser difícil de ler.

Falta de Recursos Agênticos Avançados: Atualmente, carece de integração Git nativa (por exemplo, commits/pull requests diretos) ou compreensão de imagens/mockups de UI para contexto visual.

Desafios de Adoção Empresarial: Preocupações com privacidade (código enviado ao Google), latência potencial, curva de aprendizado para nova sintaxe e comandos, modo offline limitado e compatibilidade com políticas de segurança empresariais existentes.

Pilha de Tecnologia Não-JS: Pode ter dificuldades com pilhas de tecnologia que não sejam JavaScript, como Rails ou Elixir, levando a saídas incompletas.

Os pontos fortes da CLI do Gemini se apoiam fortemente em ser “gratuita” e “de código aberto”. Embora essas sejam vantagens enormes para desenvolvedores individuais e experimentação rápida, os pontos fracos revelam as possíveis desvantagens: a “degradação do modelo no nível gratuito” afeta diretamente a qualidade e a confiabilidade percebidas, sugerindo que o aspecto “gratuito” vem com um compromisso. Da mesma forma, embora o código aberto ofereça transparência e extensibilidade, não garante automaticamente maturidade ou estabilidade, como evidenciado pelo feedback de “alfa inicial”. Isso destaca uma tensão crítica no mercado de ferramentas de IA para desenvolvedores: democratizar o acesso muitas vezes significa abrir mão de um certo nível de polimento, desempenho garantido ou suporte de nível empresarial encontrados em alternativas mais caras e de código fechado.

3.3 CLI do Gemini no VS Code

A CLI do Gemini oferece uma integração profunda com o VS Code, transformando a forma como os desenvolvedores interagem com os projetos, fornecendo sugestões sensíveis ao contexto diretamente no terminal integrado.

Recursos chave no VS Code:

Consciência de Contexto: A ferramenta se torna ciente dos arquivos abertos e pode acessar o texto selecionado, fornecendo sugestões direcionadas e contextualmente relevantes.

Visualização de Diferenças (Diffing) Nativa no Editor: As sugestões acionam uma visualização de diferenças em tela cheia diretamente no VS Code, permitindo que os usuários modifiquem o código dentro da visualização de diferenças antes de aceitar as alterações. Isso aborda uma queixa comum sobre a legibilidade das diferenças baseadas em CLI.

Servidores MCP e Ferramentas Integradas: Acesso a servidores MCP e comandos como /memory, /stats, /tools, /mcp, e ferramentas integradas (grep, terminal, leitura/escrita de arquivo, pesquisa/busca web).

Lançamento: Pode ser iniciado rapidamente a partir da Paleta de Comandos do VS Code.

A configuração requer a CLI do Gemini versão 0.1.20 ou superior e sua execução a partir do terminal integrado. Uma configuração única envolve a execução de /ide install para instalar a extensão complementar, e depois /ide enable ou /ide disable para alternar a integração.

Em comparação com o GitHub Copilot no VS Code, o Gemini Code Assist (que impulsiona a CLI do Gemini no VS Code) oferece limites de uso mais altos e geralmente melhores respostas baseadas em um contexto mais amplo devido à sua maior janela de tokens (128.000 tokens vs. incerto para o Copilot). O Gemini fornece orientações passo a passo e sugestões mais atualizadas. No entanto, o Copilot é mais rápido, oferece correções inline e possui um painel “Edit” para alterações simplificadas.

Os detalhes extensivos sobre a integração com o VS Code demonstram que o Google compreende que, embora o terminal seja o “lar” , a IDE é onde grande parte da codificação detalhada acontece. Recursos como “consciência de contexto” e “visualização de diferenças nativa no editor” são cruciais porque preenchem a lacuna entre um agente CLI e um ambiente gráfico rico. Isso sugere que o futuro da IA no desenvolvimento não é exclusivamente baseado em terminal ou em IDE, mas um modelo híbrido onde os agentes de IA podem operar perfeitamente e fornecer assistência sensível ao contexto em ambos, adaptando-se ao foco atual do desenvolvedor. Essa abordagem “híbrida” visa maximizar a produtividade, aproveitando os pontos fortes de cada ambiente.

3.4 CLI do Gemini vs. Cursor

O Cursor é uma IDE gráfica baseada no VS Code, conhecida por sua integração perfeita de IA, geração de código em tempo real, edições no contexto, depuração e pesquisa web. Ele apresenta uma curva de aprendizado menor para usuários do VS Code e oferece sugestões intuitivas em tempo real. A janela de contexto do Cursor é menor (~10k tokens no modo máximo) em comparação com os 1 milhão de tokens da CLI do Gemini, o que limita sua eficácia para bases de código massivas.

O Cursor se destaca na geração de código em tempo real e edições no contexto, mas tem dificuldades com tarefas agênticas complexas e automação de alto nível. Ele se concentra principalmente na geração/edição de código e carece de execução direta de comandos pela IA. Alguns usuários do Cursor estão considerando ou migrando para a CLI do Gemini devido ao modelo de precificação do Cursor e à vasta janela de contexto da CLI do Gemini. No entanto, alguns também observam que a CLI do Gemini pode ser problemática. Em termos de interface e experiência, o Cursor oferece uma experiência GUI rica com edições inline e feedback visual. A CLI do Gemini é baseada em terminal, o que pode ser menos intuitivo para entusiastas de IDEs. Em relação ao custo, a CLI do Gemini é gratuita, enquanto o plano Pro do Cursor é econômico para usuários de IDEs.

A comparação entre essas ferramentas destaca duas abordagens filosóficas distintas para a IA no desenvolvimento. A CLI do Gemini enfatiza o “agente conversacional” e a “ação autônoma” diretamente no terminal, com forte acesso ao sistema de arquivos e automação de ponta a ponta. O Cursor, como uma “IDE integrada à IA”, prioriza a “integração perfeita com a IDE”, “alta interatividade” e “contexto ambiente” dentro de uma GUI familiar. A “menor janela de contexto” do Cursor em comparação com a vasta janela da CLI do Gemini é um diferencial chave, influenciando sua adequação para diferentes escalas de projetos. Isso sugere que os desenvolvedores devem escolher entre uma IA que atua como um agente poderoso e autônomo (CLI do Gemini) e uma que aprimora a experiência existente da IDE com sugestões em tempo real (Cursor), cada uma com seus próprios pontos fortes e limitações. A migração de usuários mencionada indica que o tamanho da janela de contexto e o custo estão se tornando fatores decisivos críticos.

3.5 CLI do Gemini vs. Warp

O Warp é um “Ambiente de Desenvolvimento Agêntico” e uma experiência de usuário de terminal moderna com uma UI acelerada por GPU e recursos como saída baseada em blocos. Ele ocupa o primeiro lugar no Terminal-Bench. Os pontos fortes do Warp incluem ser ideal para fluxos de trabalho nativos de terminal, DevOps e agentes de implantação. Ele oferece suporte a múltiplos modelos (Claude, Gemini, GPT-4), precificação clara e geração rápida e precisa de comandos. Ele pode alternar LLMs em tempo real e escolher entre modos (agente, implantação, automático).

Em comparação, a CLI do Gemini não está listada no Terminal-Bench. O Warp se concentra em uma nova experiência de IDE centrada em agentes e melhorias de UI , enquanto a CLI do Gemini é um agente de IA de código aberto que traz o Gemini diretamente para o terminal. A CLI do Gemini funciona bem se o usuário estiver no ecossistema do Google, mas pode ter dificuldades com pilhas de tecnologia que não sejam JavaScript. O Warp é agnóstico em relação ao modelo. A CLI do Gemini oferece um nível gratuito generoso , enquanto o Warp tem preços claros. O Claude Code (e implicitamente outras CLIs) pode ser usado dentro do Warp para melhorias de UI. A conclusão é que o Warp é recomendado para uma experiência de IA nativa de terminal com suporte a implantação, infraestrutura e múltiplos agentes. O Gemini é sugerido apenas se o usuário “vive no Google Cloud”.

A comparação com o Warp revela uma nova categoria de ferramentas: “ambientes de desenvolvimento nativos de IA” ou “agênticos” que estão repensando fundamentalmente a experiência do terminal em torno da IA. Enquanto a CLI do Gemini traz a IA

para o terminal, o Warp parece reconstruir o terminal para a IA, com foco em UI/UX (UI acelerada por GPU, saída baseada em blocos) e suporte a múltiplos LLMs. Isso sugere um futuro onde o próprio terminal se torna um ambiente altamente inteligente e visualmente aprimorado, potencialmente tornando os terminais tradicionais obsoletos. A capacidade de “usar o Claude Code dentro do Warp” enfatiza ainda mais essa tendência: o ambiente do terminal (como o Warp) se torna uma camada meta que hospeda e orquestra vários agentes e modelos de IA, em vez de cada agente de IA ser uma aplicação de terminal autônoma.

3.6 CLI do Gemini vs. Claude Code

O Claude Code é um assistente de codificação de IA da Anthropic, frequentemente elogiado por sua qualidade de código e tratamento de erros. Ele é otimizado para tarefas de codificação e se destaca na compreensão profunda de bases de código, edições em múltiplos arquivos e automação Git.

Os principais diferenciais são:

Custo: A CLI do Gemini é gratuita com uma conta Google (1.000 solicitações/dia, 60/min). O Claude Code requer uma assinatura ativa da Anthropic (paga, pay-per-use) e é considerado caro, especialmente para projetos maiores.

Janela de Contexto: A CLI do Gemini possui uma janela de contexto de 1 milhão de tokens (em breve 2 milhões), ideal para grandes bases de código. O Claude Code tem uma janela de contexto de aproximadamente 200.000 tokens.

Qualidade vs. Velocidade do Código: O Gemini gera código mais rapidamente e se destaca na compreensão de grandes contextos. O Claude Code gera código de maior qualidade e é melhor no tratamento de erros e precisão. Alguns usuários consideram o Claude Code “significativamente melhor” para tarefas de codificação complexas.

Maturidade/Confiabilidade: O Claude Code é geralmente visto como mais maduro e confiável. A CLI do Gemini pode exibir um “comportamento burro e irritante”, como repetir a saída ou usar versões antigas de arquivos.

Interface/UX: O Claude Code mostra as alterações claramente no terminal e pode ser configurado para visualização de diferenças (diffing) no VS Code. O formato de visualização de diferenças da CLI do Gemini pode ser difícil de ler. O sistema de permissões do Claude Code é mais claro.

Código Aberto: A CLI do Gemini é de código aberto. O Claude Code é de código fechado.

Suporte a Plataformas: A CLI do Gemini funciona igualmente bem em Windows, macOS e Linux. O Claude Code foi otimizado primeiro para macOS.

Suporte Multimodal: A CLI do Gemini possui poderosas capacidades multimodais (imagens, PDFs). O Claude Code possui suporte multimodal limitado.

Integração de Ferramentas: A CLI do Gemini possui rica integração de ferramentas (servidores MCP). O Claude Code possui integração básica de ferramentas.

Segurança: O Claude Code oferece segurança e suporte de nível empresarial.

A escolha do usuário depende de suas prioridades:

Escolha a CLI do Gemini se custo-benefício e experimentação rápida são prioridades, se você trabalha em grandes projetos que exigem contexto massivo, prefere ferramentas de código aberto, precisa de compatibilidade entre plataformas e deseja poderosas capacidades multimodais.

Escolha o Claude Code se precisa de geração de código de alta qualidade, está construindo aplicações comerciais de missão crítica, suporte empresarial é inegociável e a qualidade do código supera as considerações de custo.

Esta comparação é talvez a mais crítica, revelando duas estratégias de produto distintas no espaço de ferramentas de IA para desenvolvedores. O modelo “gratuito” e “de código aberto” da CLI do Gemini visa ampla adoção e desenvolvimento impulsionado pela comunidade, aproveitando os vastos recursos e o ecossistema do Google. A contrapartida, como visto nas avaliações, é por vezes uma falta de polimento, consistência e suporte de nível empresarial. O Claude Code, por outro lado, adota um modelo “pago” e “de código fechado” , focando em “código de maior qualidade”, “precisão”, “tratamento de erros” e “segurança e suporte de nível empresarial”. Isso sugere uma oferta premium direcionada a usuários profissionais e empresariais, onde a confiabilidade e a qualidade são primordiais, mesmo a um custo mais alto. A diferença na “janela de contexto” (1M vs. 200K tokens) também implica diferentes casos de uso ideais: Gemini para compreensão de código em larga escala, Claude para tarefas focadas e de alta precisão. Essa divergência força os desenvolvedores a priorizar custo/acessibilidade/escala ou qualidade/confiabilidade/suporte.

3.7 CLI do Gemini vs. GitHub Copilot

O GitHub Copilot é principalmente uma extensão de IDE que fornece preenchimento de código e sugestões em tempo real.

Os principais diferenciais são:

Arquitetura/Funcionalidade: A CLI do Gemini funciona como um agente de linha de comando abrangente, utilizando um ciclo ReAct para operações complexas de várias etapas e interação com o ambiente de desenvolvimento local. O GitHub Copilot se concentra no preenchimento de código em tempo real e sugestões dentro da IDE.

Limite de Uso: O Gemini Code Assist (que inclui a CLI do Gemini) oferece limites significativamente mais altos (180.000 preenchimentos de código/mês, 240 mensagens de chat/dia) em comparação com o GitHub Copilot Free (2.000 preenchimentos/mês, 50 mensagens de chat/mês).

Custo: A CLI do Gemini é gratuita para a maioria dos desenvolvedores. O GitHub Copilot exige assinaturas pagas, embora tenha um nível gratuito limitado.

Contexto: O Gemini Code Assist inclui arquivos abertos no contexto e possui uma generosa janela de contexto de entrada de 128.000 tokens. O GitHub Copilot inclui apenas o arquivo atual por padrão, mas pode usar o contexto do espaço de trabalho com

@workspace. O Gemini geralmente gera melhores respostas com base em um contexto mais amplo.

Velocidade: O GitHub Copilot é geralmente mais rápido, enquanto o Gemini Code Assist pode apresentar um atraso perceptível.

Recursos: A CLI do Gemini oferece manipulação de arquivos, execução de comandos, solução de problemas dinâmica e integração de ferramentas externas. O Copilot possui um painel “Edit” para atualizações sugeridas e novos arquivos, e oferece correções inline. A CLI do Copilot é útil para fluxos de trabalho Git e CI/CD.

Extensibilidade: A CLI do Gemini suporta MCP para extensibilidade.

A escolha do usuário depende das necessidades: o Gemini Code Assist é melhor para muitos projetos pessoais devido aos limites de uso mais altos e explicações detalhadas. O GitHub Copilot oferece melhor integração (painel Edit) e é mais rápido se o usuário estiver disposto a pagar.

Essa comparação destaca uma evolução fundamental nas ferramentas de IA para desenvolvedores. O GitHub Copilot, embora poderoso, é principalmente uma “ferramenta de preenchimento automático” e uma “extensão de IDE que fornece preenchimento de código e sugestões em tempo real”. A CLI do Gemini, por outro lado, é um “agente” que pode “executar operações complexas de várias etapas e interagir com seu ambiente de desenvolvimento local” usando um “ciclo de raciocinar e agir (ReAct)”. Isso significa uma mudança da assistência reativa no editor para a interação proativa com o ambiente. Enquanto o Copilot aprimora o

ato de codificar, o Gemini visa automatizar fluxos de trabalho de desenvolvimento. Essa distinção é crucial para os desenvolvedores decidirem se precisam de um preenchedor automático altamente inteligente ou de um auxiliar autônomo que possa agir em seu nome.

3.8 Cline + CLI do Gemini

O Cline é um agente de codificação autônomo de código aberto que é executado diretamente na IDE do usuário. Ele enfatiza a transparência, permitindo que os usuários “vejam cada decisão” e “cada edição seja revisável”. Ele é projetado para tarefas complexas, explorando bases de código, planejando alterações e executando comandos.

Crucialmente, o Cline é “agnóstico em relação ao modelo”, o que significa que ele suporta vários provedores de API e LLMs, incluindo Google Gemini, Anthropic, OpenAI, AWS Bedrock e modelos locais. Os usuários podem escolher e alternar entre modelos com base em suas necessidades (por exemplo, Claude para raciocínio, Gemini para contextos massivos). Enquanto a CLI do Gemini é o agente de IA específico do Google, o Cline é uma

estrutura ou plataforma que pode utilizar o Gemini (entre outros modelos) como sua inteligência subjacente. A arquitetura do Cline é executada inteiramente na máquina do usuário usando suas chaves de API, garantindo que o código nunca toque nos servidores do Cline.

Recursos do Cline (relevantes para o contexto da CLI do Gemini):

Modo de Planejamento: Cria um plano abrangente antes de escrever o código.

Transparência: Visibilidade em tempo real das decisões e ações do Cline.

Domínio do Terminal: Executa comandos, lê saídas e depura erros diretamente no terminal.

Integração MCP: Conecta-se a bancos de dados, APIs e documentação através do MCP.

Código Aberto: Cada linha de código está no GitHub.

Segurança: A arquitetura do lado do cliente significa que o código nunca toca nos servidores do Cline, ideal para empresas.

Visualização de Diferenças (Diff View): Apresenta as alterações em uma visualização de diferenças dentro do editor, permitindo edições ou reversões.

A existência e os recursos do Cline revelam uma tendência significativa: o desenvolvimento de meta-ferramentas de IA que atuam como camadas de orquestração para vários LLMs subjacentes. A abordagem “agnóstica em relação ao modelo” do Cline , permitindo que os usuários “escolham qualquer modelo” como Gemini, Claude ou GPT, significa um paradigma de “Traga Seu Próprio Modelo” (BYOM). Esta é uma implicação crucial para o mercado de ferramentas de desenvolvimento de IA. Isso significa que a concorrência não é apenas entre LLMs individuais ou suas CLIs proprietárias (como a CLI do Gemini), mas também entre essas camadas de orquestração que oferecem flexibilidade, transparência e controle sobre custos e dados. O foco do Cline na “arquitetura do lado do cliente” e “suas chaves de API, sua escolha” aborda diretamente as preocupações empresariais sobre soberania de dados e dependência de fornecedor, que são frequentemente barreiras para ferramentas como a CLI do Gemini. Isso sugere que os desenvolvedores podem optar cada vez mais por essas plataformas BYOM para aproveitar os melhores recursos de diferentes LLMs, mantendo o controle sobre seu ambiente e dados.

Tabela de Comparação de Recursos da CLI do Gemini vs. Concorrentes

Recurso CLI do Gemini Claude Code Cursor Warp AI GitHub Copilot CLI

Interface Baseada em Terminal Baseada em Terminal IDE Gráfica (fork do VS Code) UX de Terminal Moderna (acelerada por GPU) Extensão de IDE / Terminal

Modelo Central Gemini 2.5 Pro (muitas vezes Flash no nível gratuito) Claude Opus 4, Sonnet 4 GPT-4, Claude (múltiplos modelos) Suporte a múltiplos LLMs (Claude, Gemini, GPT-4) OpenAI Codex

Custo Gratuito (nível generoso) / Pago (chaves de API) Pago (assinatura, pay-per-use) Pago (plano Pro econômico) Pago (preços claros) Pago (assinatura)

Código Aberto Sim Não Não Sim (para cliente central, não modelos) Não

Janela de Contexto 1M tokens (em breve 2M) ~200K tokens ~10K tokens (modo máximo) Varia conforme o LLM usado Incerto (arquivo atual, espaço de trabalho com @)

Acesso ao Sistema de Arquivos Sim (Leitura, Escrita, Execução) Sim (compreensão profunda, edições multi-arquivo) Somente leitura (para contexto), usuário escreve/salva Sim (executa comandos, lê saída) Limitado (principalmente contexto de preenchimento de código)

Capacidade Agêntica Alta (ciclo ReAct, automação de ponta a ponta) Alta (excelente em tarefas agênticas) Limitada (principalmente geração/edição de código) Alta (agentes de implantação, suporte multi-agente) Baixa (foco em sugestões, não tarefas multi-etapas)

Qualidade do Código 7.8/10 (geração mais rápida) 9.1/10 (maior qualidade, precisão) Alta (sugestões em tempo real, inteligentes) Geração de comandos rápida e precisa Boa com prompts guiados

Tratamento de Erros 7.5/10 (pode ter dificuldades, reverter contexto) 8.8/10 (melhor no tratamento de erros) Bom (depuração, feedback em tempo real) Bom (reage a problemas do servidor de desenvolvimento) Fraco

Suporte a Plataformas Windows, macOS, Linux (nativo) Otimizado para macOS (funciona em outros) Compatível com VS Code (multiplataforma) Multiplataforma Multiplataforma (extensão de IDE)

Recursos Únicos MCP, Pesquisa/Busca Web, Checkpointing, Modo Gratuito Segurança empresarial, compreensão profunda Integração perfeita com IDE, modo Composer UI acelerada por GPU, suporte multi-modelo Integração perfeita com GitHub, painel Edit

Maturidade/Estabilidade Inicial (arestas, inconsistências) Maduro, confiável Maduro, comunidade ativa Maduro, classificado em primeiro no Terminal-Bench Estabelecido

Exportar para as Planilhas

- Conclusão

A CLI do Gemini se destaca como um agente de IA poderoso, de código aberto e econômico, que traz os modelos avançados do Google Gemini diretamente para o terminal do desenvolvedor. Sua vasta janela de contexto e suas capacidades agênticas para automação de ponta a ponta são vantagens significativas.

A ferramenta é ideal para desenvolvedores individuais e pequenas equipes que buscam um companheiro de IA gratuito e versátil para codificação, depuração e gerenciamento geral de tarefas, especialmente dentro do ecossistema Google ou para grandes bases de código. Seu ciclo de desenvolvimento rápido sugere melhoria contínua.

No entanto, embora promissora, sua maturidade atual e inconsistências ocasionais (especialmente no nível gratuito) podem exigir paciência ou uma assinatura paga para ambientes de produção críticos. Os desenvolvedores devem ponderar seus benefícios em relação a alternativas mais estabelecidas, embora muitas vezes mais caras, como o Claude Code, ou considerar integrá-la dentro de meta-plataformas como o Cline para maior controle e flexibilidade.